早期脑机接口领域主要有三个大类的工作方向:把运动皮质变成遥控器;人造耳朵和人造眼;深脑刺激。

早期脑机接口类型一:把运动皮质变成遥控器

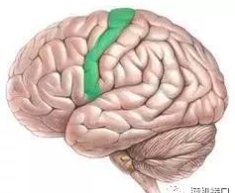

运动皮质是下面这个:

脑的所有部位对我们来说都是天书,但是运动皮质稍微不那么难懂一些。更重要的是,它和身体各部位的对应关系很好,也就是说运动皮质的特定部位是对应特定身体部位的。

同样很重要的是,运动皮质是控制我们输出行为的区域之一。当一个人做一些事情的时候,运动皮质几乎都有参于,而且至少它会参于物理运动的那部分。所以,其实人脑不需要学习怎么把运动皮质当遥控器用,因为一直以来,运动皮质都是人脑的遥控器。

试着举起你的手,然后再把手放下。发现没?你的手就好像玩具无人机一样,而你的脑就是拿起来运动皮质这个无人机遥控器,在控制着你举起和放下手。

基于运动皮质的脑机接口的目的就是能够接入运动皮质,这样当这个遥控器发出一些命令的时候,脑机接口能够收集到这个命令,然后把命令传达给一些机械,让机械做出和你的手类似的反应。神经连接你的运动皮质和你的手,而脑机接口就负责连接你的运动皮质和一台计算机,就是这么简单。

一些雏形的脑机接口,能够让一个人(通常是高位瘫痪或者截肢人士)能够通过意念就移动屏幕上的鼠标。

这种效果的实现,基于植入使用主体运动皮质的100针多电极阵列来实现。一个瘫痪了的人的运动皮质通常是没问题的,出问题的多是作为运动皮质和身体的中间人的脊髓。电极阵列植入运动皮质后,研究员会让使用主体尝试把手往不同方向移动。虽然他们的手不会真的动起来,但是运动皮质还是会正常触发的。

当一个人移动他的手臂的时候,他的运动皮质会产生一系列的行动,但是每个神经元通常只关注一个类型的运动——某个神经元可能在这个人每次把手臂往右移的时候都会触发,但是手臂往其它方向移的时候就不那么活跃了。这单个神经元,其实就能告诉计算机这个人什么时候想要把手臂往右移,什么时候又不想。但单个神经元能做到的也就是这样了。

不过随着电极阵列的接入,100个单细胞电极各自采集100个不同神经元的信息。当研究员们做测试的时候,比如研究员让测试主体把手往右边移,假设100个电极中有38个采集到各自对应的神经元触发,而当主体试图把手往左边移的时候,41个电极采集到各自对应的神经元触发。经过一系列这样的不同方向和速度的测试后,计算机能把从电极处收集到的信息分析合成为一种对于触发规律的理解,知道怎样的触发规律对应怎样的二维坐标系移动。

而当我们把这些合成结果连接到一个计算机屏幕时,测试主体就能通过“想”移动鼠标,来真正的控制鼠标,在实际操作中这种方法是可行的。经过运动皮质脑机接口的先驱BrainGate公司的努力,真的有人能够靠“想”来玩游戏。

100个神经元能够告诉我们测试主体想怎样移动鼠标,它们也完全可以告诉我们测试主体想要拿起一杯咖啡喝一口。一个四肢瘫痪的女士可以在飞行模拟中控制一架F-35战斗机。最近,有只猴子还用意念控制轮椅的移动。

而且这种控制 不止于手臂。巴西脑机接口先驱Miguel Nicolelis和他的团队就打造了一整套外骨骼,让一位瘫痪人士为巴西世界杯开球。

不要忘了本体感知

控制这些“神经义肢”的关键是记录神经元信息,但是要让它们真的高效运作起来,不能只倚赖单向的信息传输,需要一个信息采集和刺激的双向闭环。虽然我们不会注意到,但是你能够拿起一件物品,很大程度上依赖于手的皮肤发送回脑的触觉信息,也就是本体感知。

在我见过的一个视频中,一位女士的手指麻木,但没有其它残疾,而当她试图点燃火柴的时候,她做的非常困难。在另一个视频中,一位有着完好的运动皮质但是失去了本体感知的男士,也有着很严重的不便。所以要让仿生义肢真的能够像人的手臂一样运作,我们还需要让这些义肢能够把信息发送回脑里。

然而,刺激神经元比记录神经元难多了。研究员Flip Sabes是这么跟我解释的。

“好比我记录一些行为规律,但不代表我们能够轻易重现把这些规律。就好像我们的太阳系一样,你可以观测行星的移动,并且记录它们的轨迹。但如果你把太阳系打乱,然后试图重现一个行星的原本轨迹,你可不是简单的把这个行星放回它原本的轨道这么简单,因为它的行动受到其它所有行星的影响。

同样的,神经元不是独立工作的,这个过程本质上是不可逆的。同时,因为大量轴突和树突的存在,要刺激你想要刺激的神经元而不影响到其它东西,也是很难的。”

Flip的实验室尝试让脑本身来帮忙克服这些挑战。前面提到了,如果每当猴子的一个特定神经元触发后,你就给这个猴子一些奖励的话,猴子最终会学会触发这个神经元。这时,这个神经元就能被当作一种遥控器来用。也就是说,利用寻常的运动皮质的指令只是控制机制的一种可能性。

同样的,在脑机接口技术足够成熟到能够进行刺激的时候,你能把脑的神经可塑性作为一个捷径。如果让一个人的仿生手指发送回触觉信息太难实现的话,仿生义肢完全可以发送一些其它信息给脑。最初,主体对于这些信号可能不太适应,但是长此以往,脑会学会把这些信号诠释成一种新的新的触觉。这个把脑作为脑机接口的助手的概念叫作感官替代。

掩藏在这些进展之下的,是未来的技术突破,例如脑对脑沟通。

Nicolelis设计了一个实验,试验中有一只在巴西的老鼠,这个老鼠能够触摸到笼子内的两个开关,并且它知道其中一个开关能够给它带来一份小食。这只巴西老鼠的运动皮质通过互联网,连接到了一只在美国的老鼠的运动皮质。美国的老鼠处在和巴西老鼠一样的实验环境和笼子中,只不过它并不知道两个开关中哪个可以给它带来小食,并且它能收到巴西老鼠的脑发来的信号。

在实验中,如果美国老鼠做出了和巴西老鼠一样的正确选择,两只老鼠都能获得小食,而如果美国老鼠选择了错的开关,两只老鼠都得不到小食。神奇的是,经过一段时间,两只老鼠学会了合作,虽然它们不知道彼此的存在,但是两只老鼠像同一个神经系统一样工作。在完全随机的情况下,美国老鼠的成功率应该是50%,但是因为它能收到巴西老鼠发来的信号,它的成功率达到了64%。

类似的实验在真人测试中也可行。两个待在不同楼里的两个人,一起玩一个游戏,其中一个人能够看到屏幕,而另一个手握控制手柄。用简单的EEG设备,能够看到屏幕的那个玩家能够在不移动手的情况下,用意念“想”按动射击按钮。而因为两个玩家的脑设备在互相通信,手握控制手柄的玩家会感觉到手指的颤抖,然后按下射击按钮。

早期脑机接口类型二:人造耳朵和人造眼

让失聪的人恢复听觉和让失明的人回复视力是比较可控的脑机接口领域,之所以这样,是因为以下的原因:

首先,和运动皮质一样,我们对感官皮质的了解也还不错,这部分归功于感官皮质和身体部位的对应关系也比较好。

其次,在很多的早期应用中,我们不需要直接和大脑打交道,我们只需要和耳朵/眼睛连接大脑的部分打交道就可以了,因为功能丧失基本都是在这些部位发生的。

同时,运动皮质相关的工作都是通过记录神经元行为来把信息从脑取出来,人造感官则是另一个方向——刺激神经元,把信息发回脑中。

具体到人造耳的领域,近几十年我们已经在人造耳蜗领域已经有了非常长足的进展。

当你以为你“听到”声音的时候,其实整个过程是这样的:

声音其实是你的头附近的空气分子的振动。当吉他的弦,或者某人的声带,或者风,或者其它任何东西发出声音的时候,是因为发声的东西在振动,使得其周围的空气分子产生类似的振动。这种振动于是以球形传播开来,就好像你触碰到水后,水面会扩散出圆形水波一样。

你的耳朵就是把这些空气振动转化为电信号的机器。当空气(或者水,或者其它分子会振动的媒介)进入你的耳朵时,你的耳朵把空气振动的方式转化成一种电码转述给相连的神经末梢。这使得神经产生一系列的动作电位,把这些信息传送到听觉皮质里进行处理。你的脑因此就会收到这些信息,而我们把接收这类信息的体验叫作“听到”。

大多数失聪或者有听力障碍的人并没有神经问题或者听觉皮质问题,他们通常只是耳朵有问题。他们的脑和其他人的脑一样可以把电子信号转换为“听”,只是因为耳朵这个电子信号转换机器出了问题,导致他们的听觉皮质根本就没收到这些电子信号。

耳朵有很多部分组成,而耳蜗是做转换的关键部件。当分子振动进入到耳蜗内的液体的时候,振动会带动耳蜗内数千的小毛发的振动,与这些毛发相连的细胞会把振动的机械能转化为电子信号,刺激听觉神经。

耳蜗还会根据频率对声音进行分类。下面这个图解释了为啥低频声音是在耳蜗尽头处理,而高频声音是在开头处理,以及为什么耳朵能听到的声音频率会有上下限。

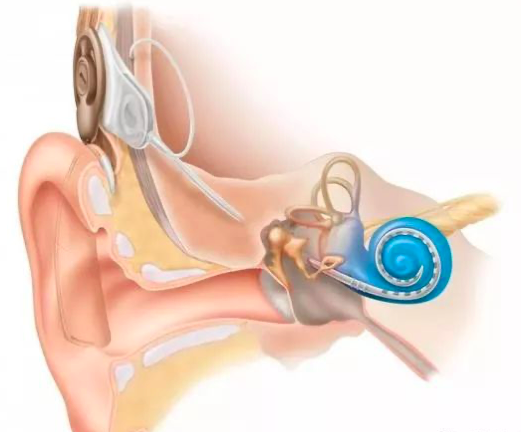

人造耳蜗就是一个小计算机,它的一端是个贴在耳朵上的小麦克风,另一端则是一条连接安装在耳蜗中的电极的电线。

声音进入到麦克风,然后进入那个褐色的组件,褐色组件会去除不是那么有用的频率范围,然后把剩下的信息通过皮肤的电传导传到计算机的另一个组件,这个组件会把信息转化成电子信号然后送入耳蜗。耳蜗里的电极和耳蜗里的毛发一样按照频率过滤脉冲信号,然后刺激听觉神经。从外面看,人造耳蜗长这个样子。

也就是说,这就是一个人造耳,这个人造耳做“声音——脉冲——听觉神经”的处理,就和人耳一样。人造耳的声音一般听起来都不怎样,为什么呢?因为要达到和人耳一样的处理效果,需要大概3500个电极,大部分人造耳蜗只有16个电极,太粗糙了。

我们现在还处在Pilot ACE时代,当然会比较粗糙了。

能让失聪的人听到声音,并且与人进行对话,这本身就是很大的进步了。

很多失聪婴儿的父母都会在婴儿一岁左右的时候把人造耳蜗植入到婴儿耳中。

在视觉领域,同样的革命也在发生,对应的例子就是人造视网膜。

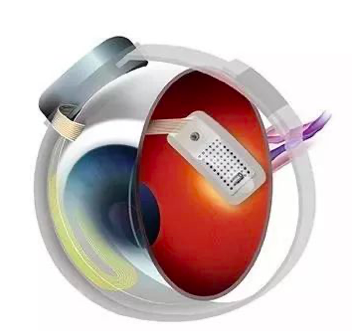

失明通常是视网膜疾病造成的。这种情况中,人造视网膜能够像人造耳蜗协助听力一样协助视觉。人造视网膜取代视网膜做眼睛本身会进行的操作,然后把电子脉冲信号传达给视觉神经。

人造视网膜是比人造耳蜗更复杂的脑机接口。第一例被美国食品药物监督管理局(FDA)批准的人造视网膜出现在2011年,它叫作Argus II,由Second Sight公司生产,它长这样:

这个人造视网膜有60个传感器,相比人类视网膜的一百万个左右的神经元,太粗糙了。不过能够看到模糊的边缘和形状,以及亮、暗的差别,怎么也好过什么都看不见了。令人振奋的是,其实我们不需要一百万个传感器来获得还过得去的视觉,模拟运算显示,600到1000个电极就能产生足够阅读和进行人脸识别的视觉。

早期脑机接口类型三:深脑刺激

早在上世纪八十年代末,深脑刺激就作为一个粗糙的工具开始改变很多人的生活了。

这个类型的脑机接口不和外部世界交流,它们是通过内部改造来治疗或者改善人体机能。

深脑刺激通常有一到两根电线,连接四个不同位置的电极,然后会插入到脑中,绝大部分会被插入到边缘系统里。然后一个连接了这些电极的小起搏器会被安装到胸口的位置,像下面这位:

当需要的时候,电极就能产生一些刺激,继而引发一些比较重要的行为发生,例如:

• 减低帕金森患者的抖动

• 减轻癫痫发作的强度

• 安抚强迫症

实验上(因为还未经FDA批准),这些设备还能减缓一些慢性疼痛,比如偏头痛和幻肢痛,治疗焦虑、抑郁和创伤后应激障碍,甚至可以结合身体其它部位的肌肉刺激来修复中风或神经疾病造成的神经损伤。

文章信息来源于Wait but Why Neuralink and the Brain’s Magical Future

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或删除,多谢。